O Google Maps é obviamente o aplicativo de mapas e navegação mais popular, não apenas no Android, mas também no iOS. É o aplicativo ideal para obter instruções e procurar bombas de gasolina, restaurantes ou hospitais nas proximidades. No entanto, um usuário do Twitter encontrou uma consulta de pesquisa depreciativa que questiona o algoritmo de pesquisa do Google, especialmente porque deixa crianças vulneráveis.

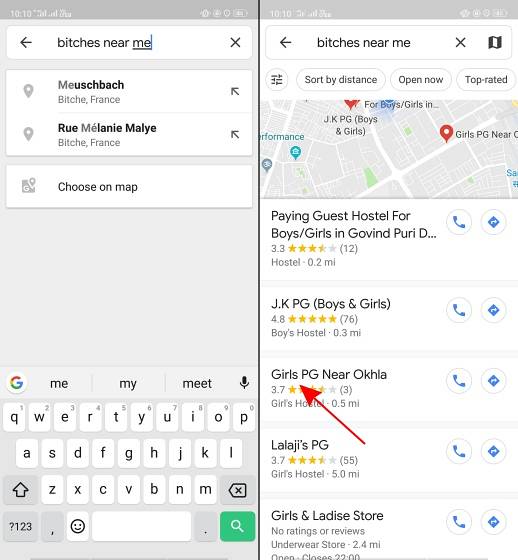

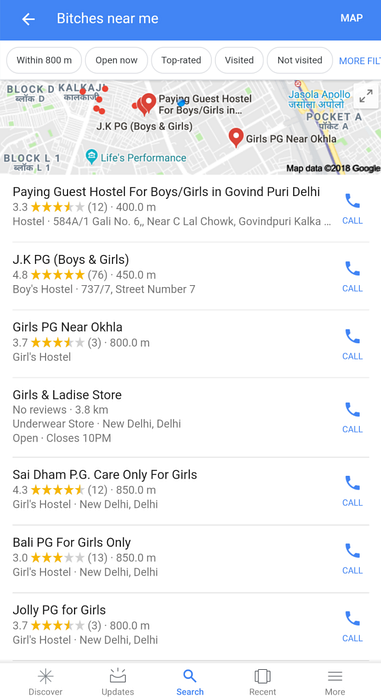

Conforme relatado pelo usuário do Twitter @AHappyChipmunk, se você abrir o Google Maps e pesquisar por “vadias perto de mim”, o resultado da pesquisa será horrível. A plataforma pega essa gíria depreciativa (que condenamos) e mostra escolas femininas, faculdades, albergues e apartamentos pagos para hóspedes, o que faz você parar por um segundo. Em um país como a Índia, onde a depreciativa palavra N é usada por setores ignorantes da população para se exibir, termos de pesquisa como cadelas não são difíceis de imaginar.

Google, você pode explicar por que essa porra existe pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25 de novembro de 2018

Este tweet foi uma surpresa terrível, mas ver o logotipo de uma conta troll no Twitter (@trollenku) me deixou cético em relação ao tweet acima, e inicialmente pensei que fosse uma piada. Somente usando a mesma consulta de pesquisa nós mesmos percebemos que não são apenas escolas - o algoritmo do Google retorna todos os lugares perto de você relacionados a meninas - incluindo aluguéis somente para meninas e outros albergues.

O mesmo se aplica às pesquisas do Google para essa frase:

É preciso entender que ninguém no Google é responsável por isso. O algoritmo do Google parece estar correlacionando cadelas com garotas, o que mais uma vez questiona o viés da IA. Afinal, uma máquina só vai aprender o que você ensina.

O resultado da pesquisa mostra o lado negro da IA e como a cultura pop pode condicioná-lo a associar certos termos a um gênero específico. Ele também destaca como pensam as pessoas que criam esses algoritmos de pesquisa. O Google deve ser particularmente cauteloso após a greve em massa de funcionários relacionada ao assédio sexual em seus escritórios no início deste mês. A alegada 'cultura do irmão' no Google também lhe rendeu um ou dois processos judiciais. E esta última gafe de IA chega em um momento em que a visibilidade é ampliada graças ao movimento #MeToo na Índia.

Muitas pessoas tweetaram para o Google para obter mais informações sobre esse algoritmo idiota. Traremos a atualização assim que recebermos uma resposta da empresa.

Gadgetshowto

Gadgetshowto