Nossa experiência em primeira mão com a tecnologia de reconhecimento de imagem de IA, Google Lens, mostrou que o aprendizado de máquina certamente percorreu um longo caminho. Mas essa tecnologia está longe de ser perfeita e não tão inteligente quanto esperávamos, principalmente porque o ritmo com que estamos treinando computadores para identificar modelos é lento. Além disso, alguns IA requerem cálculos avançados para a rede neural, e certamente não é a tarefa mais fácil ensinar uma máquina.

Tendo isso em mente, um grupo de pesquisadores do Google se encarregou de testar os sistemas de reconhecimento de imagem de IA e ver se eles podem ser enganados ou não.

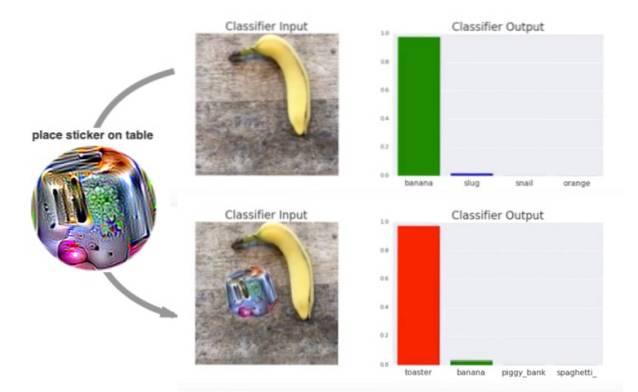

Parece que eles saíram vitoriosos desde o O sistema de IA falhou em reconhecer o objeto (aqui, uma banana) nas imagens de amostra, tudo graças a um adesivo psicodélico especialmente impresso.

A criação destes adesivos psicodélicos que podem enganar os sistemas de reconhecimento de imagens, conforme descrito em um artigo de pesquisa intitulado Adversarial Patch, que acabou de ser apresentado na 31ª conferência sobre Sistemas de Processamento de Informação Neural em dezembro de 2017. O artigo explica que os pesquisadores treinaram um sistema adversário (oponente) para criar pequenos círculos psicodélicos parecidos com manchas com formas, cores e tamanhos aleatórios para enganar o reconhecimento de imagem sistema.

Embora o método mais comum para enganar os sistemas de reconhecimento de imagem de IA seja alterar uma imagem anexando gráficos a ela, os pesquisadores do Google decidiram enganar o sistema com designs psicodélicos.

Como pode ser visto no vídeo de demonstração abaixo, o sistema é capaz de reconhecer a banana e, até certo ponto, a torradeira quando você coloca uma imagem normal ao lado da banana. Mas os resultados são menos claros quando um redemoinho psicodélico é colocado ao lado da banana:

A equipe também descobriu que um o design corrigido aparece separado do assunto e não é afetado por fatores como condições de iluminação, ângulos de câmera, objetos na visão do classificador e o próprio classificador.

Os pesquisadores continuam explicando o funcionamento dos designs psicodélicos:

Este ataque gera um patch independente de imagem que é extremamente saliente para uma rede neural. Este patch pode então ser colocado em qualquer lugar dentro do campo de visão do classificador, e faz com que o classificador produza uma classe de destino.

Embora à primeira vista isso pareça que o reconhecimento de imagem AI foi enganado, este experimento será usado para remover as inconsistências no sistema. Aqueles que trabalham neste campo agora precisam se adaptar aos dados ruidosos que podem ser incluídos nas imagens do assunto. Essa descoberta pode dar aos sistemas com aprendizado de máquina uma chance de se aprimorarem contra enganos semelhantes no futuro.

Gadgetshowto

Gadgetshowto